Rappel : ce qui m'intéresse ici, c'est l'aspect matériel de l'encodage vidéo (logiciel de montage vidéo, convertisseur…)

Quand on fait du montage vidéo, il y a 2 temps :

1) le montage proprement dit (c'est la partie la plus intéressante et la plus technique)

2) l'encodage vidéo

La seconde partie est ignorée du plus grand nombre puisqu'il s'agit, à peu de chose près, de cliquer sur le bouton "ENCODER" et d'attendre, rien de très passionnant…

Mais c'est là que se pose la question : ATTENDRE COMBIEN DE TEMPS ?

Pour ceux qui ont quelques notions hardware, ils savent qu'il faut de la puissance pour cette phase d'encodage.

Ou, autrement dit, plus le PC sera puissant, moins longue sera l'attente.

Mais de quelle puissance parle-t-on exactement ?

Beaucoup pense que c'est le CPU qui importe.

Justement NON. Pour le traitement de l'image, il existe un processeur spécialisé beaucoup plus performant que le CPU : le GPU

Autrement dit la carte graphique.

Ce n'est pas pour rien que les gamers dépensent des sommes colossales pour des cartes graphiques indispensables pour jouer.

Vous aurez beau prendre le CPU le plus puissant du marché, sans carte graphique, il est impossible de jouer.

On pourrait "presque" dire la même chose avec l'encodage vidéo.

"Presque", car même sans carte graphique on peut cliquer sur le bouton "ENCODER" et l'encodage se fera...à une vitesse d'escargot, mais se fera quand même.

Donc, quand on veut faire de l'encodage vidéo, c'est un peu le même "combat" que les gamers : machine puissante...à tous les niveaux.

"A tous les niveaux", cela veut dire puissance CPU MAIS AUSSI puissance graphique (sans parler de la RAM, de disques rapides…)

En réalité, les cartes graphiques spécialisées pour le travail de l'image (vidéo ou non), ce sont des cartes du genre NVidia Quadro.

Ce ne sont absolument des cartes conçues pour jouer mais traiter l'image.

7 340 € la carte !

Il en existe de moins chère.

Mais pour un particulier qui joue également, en plus d'encoder des vidéos, il vaut mieux prendre un carte graphique dédiée au jeu, certes moins performante qu'une NVidia Quadro mais bien plus efficace que n'importe quel CPU.

Dans le post précédent, le but était de montrer que le GPU (= la carte graphique) était bien plus performante quand il s'agit d'encoder des images que le CPU.

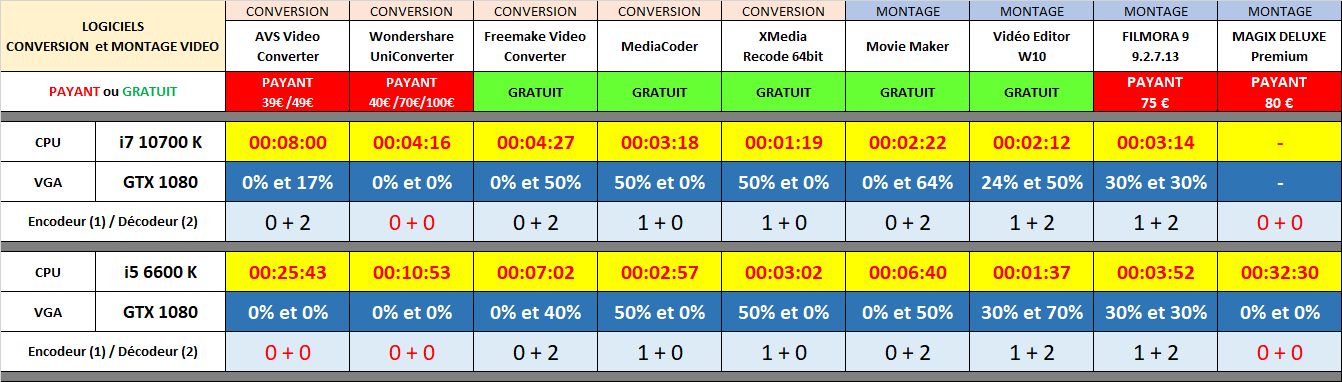

Divers tests avaient été effectuées et le CPU utilisé était un i5 6600k overclocké à 4,8 GHz.

Le 6600k est à présent remplacé par Core i7 10700k overclocké à 5,1 GHz.

On passe donc d'un CPU à 4 cœurs, le 6600k, à un CPU à 16 cœurs (8 cœurs physiques + 8 cœurs logiques).

Donc un CPU bien plus puissant.

Les mêmes tests ont été effectués, la carte graphique étant toujours la même : GEFORCE 1080 GTX

Evidemment, ce tableau demande quelques éclaircissements.

On peut dire, schématiquement, qu'il y a les "bons" logiciels et les "mauvais" logiciels.

Les "bons" logiciels sont ceux qui utilisent le GPU plutôt que le CPU = le temps d'encodage est beaucoup plus court.

Les "bons" logiciels sont ceux qui utilisent le GPU plutôt que le CPU = le temps d'encodage est beaucoup plus court.

les logiciels "moyens" sont ceux qui utilisent en partie le GPU = le temps d'encodage est moins rapide qu'avec le GPU bien utilisé mais plus rapide qu'avec le CPU.

les logiciels "moyens" sont ceux qui utilisent en partie le GPU = le temps d'encodage est moins rapide qu'avec le GPU bien utilisé mais plus rapide qu'avec le CPU.

Les "mauvais" logiciels sont ceux qui utilisent le CPU plutôt que le GPU = le temps d'encodage est beaucoup plus long.

Les "mauvais" logiciels sont ceux qui utilisent le CPU plutôt que le GPU = le temps d'encodage est beaucoup plus long.

Evidemment, quand un logiciel ne sait pas utiliser le GPU, il ne reste plus que le CPU pour faire le boulot.

Dans ce cas, évidemment, plus le CPU sera puissant, plus court sera le temps d'encodage.

Dans ce tableau, quels sont les "mauvais logiciels" ?

Les logiciels payants ! Hormis Filmora. Comme quoi, concernant les logiciels, le prix n'est pas forcément une garantie de qualité.

Les logiciels payants ! Hormis Filmora. Comme quoi, concernant les logiciels, le prix n'est pas forcément une garantie de qualité.

Plus sérieusement, on reconnait les mauvais logiciels dans ce tableau, à 2 choses :

le temps d'encodage (cela parait évident !)

le temps d'encodage (cela parait évident !)

l'usage limité ou inexistant du GPU

l'usage limité ou inexistant du GPU

Pour chaque CPU, dans ce tableau, il y a une ligne : Encodeur(1)/Décodeur(2)

Quand vous lisez 0 + 0 , cela signifie que le logiciel n'utilise aucunement le GPU, ni en encodage, ni en décodage le temps d'encodage est désastreux

le temps d'encodage est désastreux

Quand vous lisez 0 + 2 , cela signifie que le logiciel n'utilise le GPU que pour le décodage le temps d'encodage est moyen

le temps d'encodage est moyen

Quand vous lisez 1 + 0 ou 1 + 2 cela signifie que le logiciel utilise le GPU pour le l'encodage ou pour l'encodage et le décodage le temps d'encodage est bon

le temps d'encodage est bon

Bref, les meilleurs logiciels, ceux qui ont les temps d'encodage les plus courts, sont tous les logiciels qui utilisent le GPU pour l'encodage.

Evidemment, le GPU étant meilleur que le CPU, quand c'est le GPU qui travaille pour l'encodage, les temps sont plus courts.

EXPLOITATION DU TABLEAU

On rappelle que but est de voir, ou pas, l'incidence du i7 10700k sur ces tests.

Alors ? Quelle conclusion ?

Ce sera une réponse de normand, oui et non.

1) OUI, le Core i7 10700k a une grande incidence avec les "mauvais logiciels", ceux qui ne savent pas utiliser la carte graphique.

En effet, avec les "mauvais logiciels", c'est comme s'il n'y avait pas de GPU.

Donc, c'est le CPU qui doit gérer seul l'encodage vidéo.

Et dans ce cas, c'est évident, plus le CPU sera puissant moins l'encodage sera long.

Le Core i7 10700k a également une incidence importante avec les "logiciels moyens", ceux qui n'utilisent pas la carte graphique qu'en partie, uniquement pour le décodage.

Prenons un exemple d'un "mauvais logiciel" comme AVS :

avec le i5 6600k (4 cœurs) : 26 minutes d'encodage (pour un film HD 1920 x 1080 de 16 minutes)

avec le i5 6600k (4 cœurs) : 26 minutes d'encodage (pour un film HD 1920 x 1080 de 16 minutes)

avec le i7 10700k (16 cœurs) : 8 minutes d'encodage

avec le i7 10700k (16 cœurs) : 8 minutes d'encodage

Le temps a été divisé par 3

Oui mais...la machine avec le i5 6600k, quand le GPU est utilisé grâce à un "bon logiciel" : 3 minutes

Soit un temps encore moitié moins long !

Alors la question est :

vaut-il mieux un GROS I7 10700k pour encoder en 8 minutes ?

vaut-il mieux un GROS I7 10700k pour encoder en 8 minutes ?

ou vaut-il mieux un PETIT I5 6600K (+ GPU) pour encoder en 3 minutes ?

ou vaut-il mieux un PETIT I5 6600K (+ GPU) pour encoder en 3 minutes ?

Car honnêtement, si j'investis dans un coûteux Core i7 10700k de 10ème génération avec 16 threads et qu'un petit Core i5 6600k de 6ème génération avec seulement 4 threads met plus de 2 fois moins de temps (3 minutes pour le i5 600k contre 8 minutes pour le i7 10700k), n'est-ce pas un peu les boules ?

C'est les boules car j'ai fait un mauvais choix, j'ai misé sur le mauvais cheval.

Un peu comme si j'achetais une Porsche coûteuse pour labourer mon champ.

Or, pour labourer un champ, la voiture de sport la plus puissante du monde ne vous sera d'aucune utilité : il faut un tracteur

Le "tracteur" de l'encodage vidéo, c'est le GPU.

Une fois que l'on a compris cela, plutôt que d'acheter un "SUPER CPU DE LA MORT QUI TUE" et faire stupidement l'impasse sur la carte graphique, je vais plutôt me contenter d'un CPU "moyen", genre un Core i5 (ce n'est déjà pas mal du tout) et, SURTOUT, je vais ajouter une carte graphique la plus puissante possible en fonction de mon budget.

Ce qui nous amène à la seconde réponse :

1) NON, le Core i7 10700k n'a pas une grande incidence avec les "bons logiciels", ceux qui savent pas utiliser la carte graphique.

En effet, regardons quelques résultats pour les "bons logiciels" :

Mediacoder

Mediacoder  2'57" pour le i5 et 3'18" pour le i7

2'57" pour le i5 et 3'18" pour le i7

Xmedia

Xmedia  3'02" pour le i5 et 1'19" pour le i7

3'02" pour le i5 et 1'19" pour le i7

Filmora

Filmora  3'52" pour le i5 et 3'14" pour le i7

3'52" pour le i5 et 3'14" pour le i7

On voit bien que les résultats se tiennent dans un mouchoir de poche et que le Core i7 10700k ne change pas vraiment la donne.

Il faut tout de même reconnaître que le i7 améliore légèrement le résultat pour Filmora et un peu plus avec Xmedia.

Xmedia, visiblement, en plus d'utiliser efficacement le GPU utilise aussi très bien le CPU d'où ce score impressionnant de 1'19" !

Petite incohérence, apparemment avec Mediacoder dont le score est supérieur avec le Core i5.

Cela s'explique par le fait que le GPU était overclocké avec le i5 6600k, ce qui n'est pas le cas avec le i7 10700k.

Et, comme visiblement, Mediacoder utilise massivement le GPU et fort peu le CPU, l'overclocking du GPU avec le i5 permet de comprendre ce score légèrement à l'avantage du i5.

Quand on fait du montage vidéo, il y a 2 temps :

1) le montage proprement dit (c'est la partie la plus intéressante et la plus technique)

2) l'encodage vidéo

La seconde partie est ignorée du plus grand nombre puisqu'il s'agit, à peu de chose près, de cliquer sur le bouton "ENCODER" et d'attendre, rien de très passionnant…

Mais c'est là que se pose la question : ATTENDRE COMBIEN DE TEMPS ?

Pour ceux qui ont quelques notions hardware, ils savent qu'il faut de la puissance pour cette phase d'encodage.

Ou, autrement dit, plus le PC sera puissant, moins longue sera l'attente.

Mais de quelle puissance parle-t-on exactement ?

Beaucoup pense que c'est le CPU qui importe.

Justement NON. Pour le traitement de l'image, il existe un processeur spécialisé beaucoup plus performant que le CPU : le GPU

Autrement dit la carte graphique.

Ce n'est pas pour rien que les gamers dépensent des sommes colossales pour des cartes graphiques indispensables pour jouer.

Vous aurez beau prendre le CPU le plus puissant du marché, sans carte graphique, il est impossible de jouer.

On pourrait "presque" dire la même chose avec l'encodage vidéo.

"Presque", car même sans carte graphique on peut cliquer sur le bouton "ENCODER" et l'encodage se fera...à une vitesse d'escargot, mais se fera quand même.

Donc, quand on veut faire de l'encodage vidéo, c'est un peu le même "combat" que les gamers : machine puissante...à tous les niveaux.

"A tous les niveaux", cela veut dire puissance CPU MAIS AUSSI puissance graphique (sans parler de la RAM, de disques rapides…)

En réalité, les cartes graphiques spécialisées pour le travail de l'image (vidéo ou non), ce sont des cartes du genre NVidia Quadro.

Ce ne sont absolument des cartes conçues pour jouer mais traiter l'image.

7 340 € la carte !

Il en existe de moins chère.

Mais pour un particulier qui joue également, en plus d'encoder des vidéos, il vaut mieux prendre un carte graphique dédiée au jeu, certes moins performante qu'une NVidia Quadro mais bien plus efficace que n'importe quel CPU.

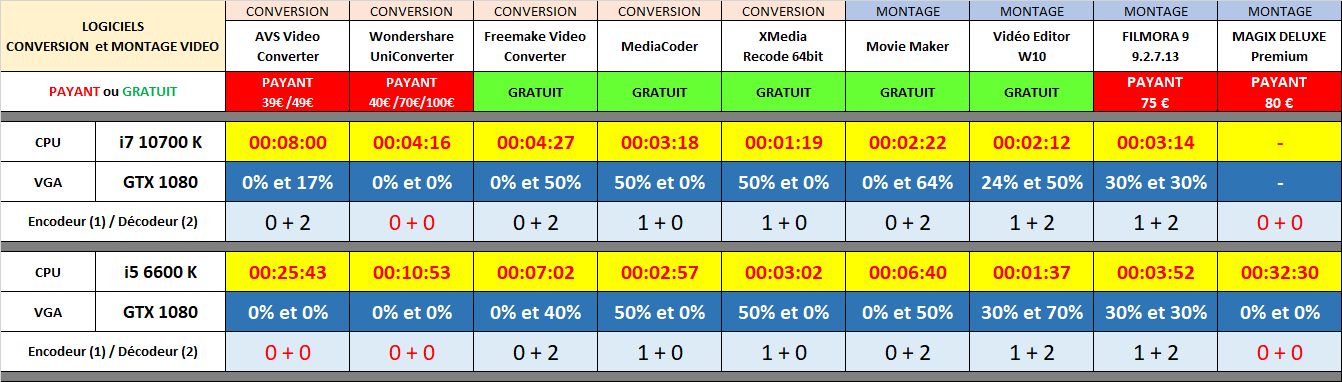

Dans le post précédent, le but était de montrer que le GPU (= la carte graphique) était bien plus performante quand il s'agit d'encoder des images que le CPU.

Divers tests avaient été effectuées et le CPU utilisé était un i5 6600k overclocké à 4,8 GHz.

Le 6600k est à présent remplacé par Core i7 10700k overclocké à 5,1 GHz.

On passe donc d'un CPU à 4 cœurs, le 6600k, à un CPU à 16 cœurs (8 cœurs physiques + 8 cœurs logiques).

Donc un CPU bien plus puissant.

Les mêmes tests ont été effectués, la carte graphique étant toujours la même : GEFORCE 1080 GTX

Evidemment, ce tableau demande quelques éclaircissements.

On peut dire, schématiquement, qu'il y a les "bons" logiciels et les "mauvais" logiciels.

Evidemment, quand un logiciel ne sait pas utiliser le GPU, il ne reste plus que le CPU pour faire le boulot.

Dans ce cas, évidemment, plus le CPU sera puissant, plus court sera le temps d'encodage.

Dans ce tableau, quels sont les "mauvais logiciels" ?

Plus sérieusement, on reconnait les mauvais logiciels dans ce tableau, à 2 choses :

Pour chaque CPU, dans ce tableau, il y a une ligne : Encodeur(1)/Décodeur(2)

Quand vous lisez 0 + 0 , cela signifie que le logiciel n'utilise aucunement le GPU, ni en encodage, ni en décodage

Quand vous lisez 0 + 2 , cela signifie que le logiciel n'utilise le GPU que pour le décodage

Quand vous lisez 1 + 0 ou 1 + 2 cela signifie que le logiciel utilise le GPU pour le l'encodage ou pour l'encodage et le décodage

Bref, les meilleurs logiciels, ceux qui ont les temps d'encodage les plus courts, sont tous les logiciels qui utilisent le GPU pour l'encodage.

Evidemment, le GPU étant meilleur que le CPU, quand c'est le GPU qui travaille pour l'encodage, les temps sont plus courts.

EXPLOITATION DU TABLEAU

On rappelle que but est de voir, ou pas, l'incidence du i7 10700k sur ces tests.

Alors ? Quelle conclusion ?

Ce sera une réponse de normand, oui et non.

1) OUI, le Core i7 10700k a une grande incidence avec les "mauvais logiciels", ceux qui ne savent pas utiliser la carte graphique.

En effet, avec les "mauvais logiciels", c'est comme s'il n'y avait pas de GPU.

Donc, c'est le CPU qui doit gérer seul l'encodage vidéo.

Et dans ce cas, c'est évident, plus le CPU sera puissant moins l'encodage sera long.

Le Core i7 10700k a également une incidence importante avec les "logiciels moyens", ceux qui n'utilisent pas la carte graphique qu'en partie, uniquement pour le décodage.

Prenons un exemple d'un "mauvais logiciel" comme AVS :

Le temps a été divisé par 3

Oui mais...la machine avec le i5 6600k, quand le GPU est utilisé grâce à un "bon logiciel" : 3 minutes

Soit un temps encore moitié moins long !

Alors la question est :

Car honnêtement, si j'investis dans un coûteux Core i7 10700k de 10ème génération avec 16 threads et qu'un petit Core i5 6600k de 6ème génération avec seulement 4 threads met plus de 2 fois moins de temps (3 minutes pour le i5 600k contre 8 minutes pour le i7 10700k), n'est-ce pas un peu les boules ?

C'est les boules car j'ai fait un mauvais choix, j'ai misé sur le mauvais cheval.

Un peu comme si j'achetais une Porsche coûteuse pour labourer mon champ.

Or, pour labourer un champ, la voiture de sport la plus puissante du monde ne vous sera d'aucune utilité : il faut un tracteur

Le "tracteur" de l'encodage vidéo, c'est le GPU.

Une fois que l'on a compris cela, plutôt que d'acheter un "SUPER CPU DE LA MORT QUI TUE" et faire stupidement l'impasse sur la carte graphique, je vais plutôt me contenter d'un CPU "moyen", genre un Core i5 (ce n'est déjà pas mal du tout) et, SURTOUT, je vais ajouter une carte graphique la plus puissante possible en fonction de mon budget.

Ce qui nous amène à la seconde réponse :

1) NON, le Core i7 10700k n'a pas une grande incidence avec les "bons logiciels", ceux qui savent pas utiliser la carte graphique.

En effet, regardons quelques résultats pour les "bons logiciels" :

On voit bien que les résultats se tiennent dans un mouchoir de poche et que le Core i7 10700k ne change pas vraiment la donne.

Il faut tout de même reconnaître que le i7 améliore légèrement le résultat pour Filmora et un peu plus avec Xmedia.

Xmedia, visiblement, en plus d'utiliser efficacement le GPU utilise aussi très bien le CPU d'où ce score impressionnant de 1'19" !

Petite incohérence, apparemment avec Mediacoder dont le score est supérieur avec le Core i5.

Cela s'explique par le fait que le GPU était overclocké avec le i5 6600k, ce qui n'est pas le cas avec le i7 10700k.

Et, comme visiblement, Mediacoder utilise massivement le GPU et fort peu le CPU, l'overclocking du GPU avec le i5 permet de comprendre ce score légèrement à l'avantage du i5.